0 498 2021-05-20 10:00:01

收藏

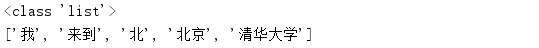

seg_list = jieba.lcut("我来到北北京清华大学")

print(type(seg_list))

print(seg_list)

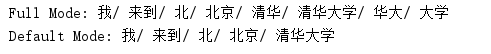

2.jieba.cut(sentence, cut_all=False):返回的是一个迭代器,cut_all默认为False(精确模式),True(全模式)

seg_list = jieba.cut("我来到北北京清华大学", cut_all=True) # 结巴分词用于中文分词

print("Full Mode:", "/ ".join(seg_list)) #全模式:将语句所有可以组合的词分出来

seg_list = jieba.cut("我来到北北京清华大学", cut_all=False)

print("Default Mode:", "/ ".join(seg_list)) # 精确模式:将语句划分开

seg_list = jieba.cut("他来到了了网网易易杭研大大厦")

print(", ".join(seg_list))

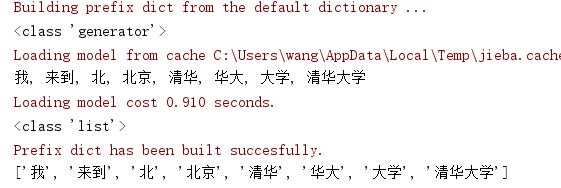

3.jieba.cut_for_search(sentence):返回一个迭代器

jieba.lcut_for_search(sentence):返回一个集合

搜索引擎模式:在精确模式的基础上,对长词在此划分,

seg_list = jieba.cut_for_search("我来到北北京清华大学")

print(type(seg_list))

print(", ".join(seg_list))

seg_list = jieba.lcut_for_search("我来到北北京清华大学")

print(type(seg_list))

print(seg_list)

分词无论是全模式还是搜索引擎模式都是不会改变语句顺序的,即使语句中一些不相邻的字可以组成一个词,结巴分词并不会把他们划分为一个词。

本文地址:https://xzo.com.cn/develop/python/969.html

如果您认可我们的分享,有意与我们合作开展帝国cms网站建设与开发业务或插件定制,请联系右侧在线客服。我们能给您的,就是高质量的模板与售后。

标注了信息来源为下载鸥的文章皆为原创,如果是转载的优质文章,我们也都标注了出处。如果您喜欢我们的文章,请按照下载鸥所标注的文章出处进行标注,谢谢您的配合。

Python免费、开源、简单,且含有海量的库。其功能也十分强大,不仅可以做网站、做爬虫、还可以做大数据、做人脸识别,等等等等。如果是新手入门,我们建议是首选Python。

国内知名度比较高的Python中文分词有哈工大LTP、中科院计算所NLPIR、清华大...

结巴分词支持3种模式:全模式、精确模式和搜索引擎模式,不同的模式效果会有差...

但凡对电脑知识了解多一点的朋友可能就听说过进程,而如果对蜘蛛爬虫有了解,那...

python爬虫爬取百度图片是很多人python爬虫入门后一个重要的练手项目。一方...

爬虫软件很多,支持爬虫功能的语言也很多,而用python做爬虫,辅以包罗万象的pyth...

用户体验是我们的需求,百度蜘蛛的认可更是我们的需求。毕竟,没有收录排名,何来...

百度开放了系列AI功能api如图像上色、图像去雾、图像修复、无损放大、清晰...

帝国cms有自带的给关键词添加内链功能,但需要手动添加关键词,容易出现疏漏和...

帝国cms 对接纳米数据(www.nami.com)接口,本接口主要接收、整理足球比赛实时数...

采集站的必备资源是自动审核,要做到日收录也离不开定时发布。而本插件的自动...

下载鸥开发了这款帝国cms封禁ip插件,自动记录访问情况,让我们可以更快的识别...

帝国CMS自带的搜索功能虽然强大,但也有很强的局限性 -- 必须关键词完全匹配...

通过本插件,可以实现帝国cms网站对接百度云api实现图像清晰度增强的功能。经...